多模态大模型空间智能取得新进展:认知地图助力视觉空间推理

斯坦福大学教授李飞飞,被誉为“AI教母”,在最新的研究中揭示了多模态大模型在空间推理能力上的进展。尽管这些模型在这一领域的能力仍然不及人类,但它们已经能够记住和回忆特定的空间布局,并且似乎内部形成了局部的世界模型,这表明了一定程度的空间意识。

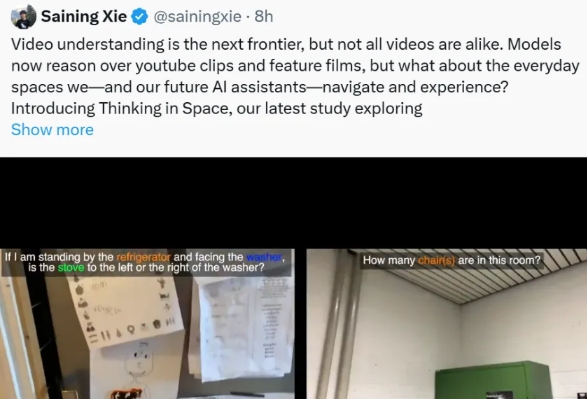

研究人员开发了一个名为VSI-Bench的工具,用来评估多模态大模型的视觉空间智能。该工具基于超过5000个问答对,这些问答来源于288个真实视频,涵盖了居住空间、专业场所如办公室和实验室、以及工业环境如工厂等场景,同时考虑了多个地理区域。VSI-Bench经过精心设计,以确保问题清晰明确,并剔除了源数据集中的错误标注,保证了其高质量。

通过VSI-Bench的测试,多模态大模型展现出了竞争性的视觉空间智能,不过整体性能仍低于人类的表现。例如,在配置和时空任务上,人类评估者的平均准确率为79%,而表现最佳的模型准确率低了33个百分点。然而,某些专有模型,像Gemini-1.5 Pro,即使只接受过2D数字数据训练,也能够在绝对距离和房间大小估计等任务中接近人类水平。开源模型中LLaVA-NeXT-Video-72B和LLaVA-OneVision-72B同样表现出色,与Gemini-1.5 Pro相比差距不大。相反,多数开源模型则未能达到基本标准。

研究还探讨了提高模型空间智能的方法。实验显示,传统语言提示技术如思维链或思维树并未能提升空间任务的表现,反而可能带来负面影响。相比之下,生成认知地图以辅助空间推理被证明是有效的,它能使模型在空间任务上的准确性显著提升。此外,论文共同作者之一谢赛宁提到,随着这项研究的推进,视觉空间智能的应用前景变得更加广阔,比如AI眼镜可以帮助用户回忆曾经去过的地方并提供导航服务。

李飞飞认为,空间智能是机器理解物理世界的关键,她将此视为实现通用人工智能的重要一步。她强调,未来的突破不仅需要增强模型处理二维图像的能力,更需要发展三维立体的理解力,这是World Labs正在努力的方向。该公司旨在构建一种可以真正理解实体世界的模型,并且已经得到了知名投资机构的支持,成为AI领域的焦点之一。

主流币行情

相关阅读

多模态大模型空间智能取得新进展:认知地图助力视觉空间推理

OpenAI的GPT-5面临重重挑战:从数据短缺到人才流失,未来前景不明朗

哪吒汽车创始人方运舟股权遭冻结,兼任CEO直面公司改革挑战

大宗商品主题ETF在市场下行中逆势吸金,黄金与豆粕成资金避风港

银行股与培育钻石逆势上扬,市场普跌中小盘股承压显著

百川智能发布金融大模型Baichuan4-Finance,整体准确率领先GPT-4o近20%

12月23日午间收评:上证50指数半日涨1.38%,工商银行、建设银行股价创新高

12月23日上午复盘

SK海力士加快16层HBM3E量产进度,明年上半年量产供货

荣耀成立4家新公司,含智能机器人及无人飞行器业务